Google Gemma3 最先端AIモデルの全貌と活用について

Gemma3とは、一言でいうと「Googleが開発した、最新かつ高性能な『オープンソース』のAIモデルファミリー」のことです。

Googleの最先端AIモデル「Gemini」と同じ研究と技術に基づいて作られており、その高い能力の一部を、世界中の開発者や研究者が無料で利用し、自由に改良できるように公開(オープンソース化)されています。Gemmaシリーズの最新版がこのGemma3です。

- Gemma3の機能や性能の詳細

- Geminiや他の主要AIモデル(Llama 3, DeepSeekなど)との比較

- ビジネス、研究、教育などでの具体的な活用事例

- 無料でGemma3を使い始めるための具体的なステップ(使い方ガイド)

この記事を読み終える頃には、Gemma3の全体像をしっかりと理解し、この最先端のオープンソースAIをあなたの目的達成のためにどのように活用できるか、具体的なイメージを描けるようになっているはずです。

【1分で完了】AI活用度診断

あなたのAI活用度を5つの観点で診断し、レーダーチャートで可視化。得意分野と伸ばすべきAIスキルが一目でわかります。

診断は無料で1分程度で完了するので、自分のAIスキルを伸ばしたい方はぜひ診断してみてください。

Gemma3とは?そのな特徴

Geminiとの関係性とGemmaモデルファミリーにおける位置づけ

Gemmaは、Googleの最先端AIモデルであるGeminiと同じ研究開発チームによって生み出された、軽量で高性能なオープンソースAIモデルのファミリーです。

Geminiの技術的な系譜を受け継ぎ、AI開発コミュニティのイノベーションを促進するために開発されました。Gemmaファミリーには、以前のリリースであるGemma 1やGemma 2があり、Gemma3はその成功に基づいて構築された、最も能力が高く、先進的なバージョンです。

Geminiがクローズドソースであるのに対し、Gemmaはオープンソースとして公開されており、誰でも無料でダウンロードして利用できる点が大きな違いです。このオープンな性質により、Gemmaはより柔軟なカスタマイズ、ローカル環境での展開、そして幅広い研究開発への貢献が期待されています。

マルチモーダル機能(画像とテキストの入力)の詳細

Gemma3の最も革新的な特徴の一つが、マルチモーダル機能の導入です。これにより、テキストだけでなく画像も入力として処理し、それに基づいてテキストを出力することが可能になりました。

具体的には、画像を解釈したり、画像内の物体を認識したり、画像からテキストデータを抽出したり、あるいは画像の内容に基づいて質問に答えたりするなど、多様な視覚入力からテキスト出力を生成するタスクを実行できます。

このマルチモーダル機能は、4B、12B、27Bのパラメータを持つモデルで利用可能であり、これらのモデルは共通してSigLIPという400Mパラメータのビジョンエンコーダーを搭載しています。SigLIPは、画像理解に特化した事前学習済みモデルであり、Gemma3に高度な視覚認識能力を与えています。

さらに、Gemma3は推論時に「Pan & Scan」と呼ばれる手法を用いて、非正方形や高解像度の画像にも対応します。この技術により、画像を複数の小さな領域に分割し、それぞれを処理することで、高解像度画像の詳細な分析や、異なるアスペクト比の画像への柔軟な対応が可能になります。ただし、最も軽量なモデルであるGemma3 1Bはテキスト専用であり、画像入力はサポートされていません。

128Kトークンという広大なコンテキストウィンドウがもたらす利点

Gemma3の4B、12B、27Bの各モデルは、最大128Kトークンという非常に大きなコンテキストウィンドウをサポートしています。これは、以前のGemmaモデルと比較して16倍もの拡張であり、1Bモデルでも32Kトークンのコンテキストウィンドウが提供されます。

この広大なコンテキストウィンドウにより、Gemma3は非常に多くの情報を一度に処理できるようになります。例えば、複数ページの論文、長編の記事、あるいは数百枚の画像などを単一のプロンプトで分析することが可能です。これは、長期的な記憶と広範な文脈の理解が求められるタスク、例えば、書籍全体の要約、長時間の会話履歴を考慮したチャットボットの構築、あるいは詳細な分析が必要なレポートの処理などにおいて、非常に大きな利点となります。

従来の言語モデルでは、コンテキストウィンドウの制限により、長い文章の一部しか考慮できなかったため、Gemma3のこの機能は、より高度で複雑なAIアプリケーションの開発を可能にする重要な要素と言えるでしょう。

140以上の言語をサポートする多言語対応

Gemma3は、140以上の言語をネイティブにサポートする強力な多言語対応能力を備えています。これは、以前のGemmaバージョンと比較しても大幅な言語対応範囲の拡大であり、ユーザーは自身の母語で作業したり、グローバルなオーディエンスに向けたアプリケーションを開発したりすることが容易になります。

この広範な言語サポートは、Gemini 2.0のトークナイザーを活用することで実現されており、特に中国語、日本語、韓国語といったアジア言語のエンコーディングが改善されています。

これにより、多言語でのコンテンツ作成、翻訳支援、そしてグローバルな市場に向けたアプリケーションのローカライズなどがよりスムーズに行えるようになります。

関数呼び出し機能による外部システムとの連携の可能性

Gemma3は、関数呼び出し(Function Calling)機能をサポートしており、これによりプログラミングインターフェースに対するインテリジェントで自然な言語制御を構築できます。

開発者は、特定の構文と制約を持つコーディング関数を定義することができ、Gemma3はその関数を呼び出してタスクを完了させることが可能です。この機能により、Gemma3は外部システムやAPIと連携し、データの取得や特定のアクションの実行など、単なるテキスト生成を超えたインタラクションを実現する可能性を秘めています。

例えば、天気APIを呼び出して現在の天気をユーザーに伝えたり、株価APIと連携して最新の株価情報を提供したりするようなアプリケーションを構築できます。ただし、Gemmaの組み込みの関数呼び出し機能は、より特化したエージェントAIシステムと比較すると、まだ発展の余地があると考えられます。

Gemma3の技術的側面の高性能の秘密について

Transformerアーキテクチャの概要とGemma3における最適化

Gemma3の高性能は、その基盤となるTransformerアーキテクチャと、Gemma3に施された様々な最適化技術によって支えられています。

Transformerは、自然言語処理において非常に強力なモデルアーキテクチャであり、特に文章内の単語間の関係性を捉えるAttentionメカニズム(Self-Attention、Multi-Head Attention)が重要な役割を果たします。

Gemma3は、入力シーケンスを事前に処理するエンコーダーを持たない、デコーダー専用のTransformerアーキテクチャを採用しており、一度に一つのトークンを出力することでテキストを生成します。

Gemma3における重要な最適化の一つが、インターリーブされたローカル・グローバルAttentionメカニズムです。これは、5つのローカルAttentionレイヤーに対して1つのグローバルAttentionレイヤーを配置する構造であり、ローカルAttentionは1024トークンの短いスライディングウィンドウに焦点を当てる一方、グローバルAttentionは入力全体の文脈を考慮します。この仕組みにより、長い文脈を効率的に処理し、計算コストを削減することが可能になります。

また、長距離の依存関係をより適切に処理するために、グローバルレイヤーにおけるRoPE(Rotary Position Embeddings)のベース周波数が1Mに増加しています。さらに、推論時のメモリフットプリントを大幅に削減するために、KV(Key-Value)キャッシュの削減技術が導入されています。

学習に使用されたデータセットとトレーニングプロセス

Gemma3は、数兆トークンにも及ぶ膨大なテキストデータセットで学習されています。モデルのサイズによって学習に使用されたトークン数は異なり、例えば27Bモデルでは14兆トークン、12Bモデルでは12兆トークン、4Bモデルでは4兆トークン、そして1Bモデルでは2兆トークンが使用されました。

このトレーニングデータセットは、140以上の言語のウェブテキスト、数学、画像など、多様なソースから構成されています。Gemma3のトレーニングプロセスは、最適化された事前学習と事後学習の段階を経ており、事後学習には、より能力の高いモデルからの知識を転移させる蒸留(Distillation)、人間のフィードバックを用いた強化学習(RLHF)、機械フィードバックを用いた強化学習(RLMF)による数学的推論能力の向上、そして実行フィードバックを用いた強化学習(RLEF)によるコーディング能力の強化 などが含まれます。

トレーニングには、GoogleのTPU(Tensor Processing Unit)とJAXフレームワークが使用されており、TPUは機械学習で一般的な行列演算に特化したハードウェアであり、高いパフォーマンス、メモリ帯域幅、スケーラビリティ、そしてコスト効率を提供します。

また、トレーニングデータから個人情報、有害なコンテンツ、重複などを排除するために、広範なデータフィルタリング技術が用いられています。

モデルのパラメータサイズと量子化が利用シーンに与える影響

Gemma3は、1B、4B、12B、27Bの4つの異なるパラメータサイズで提供されています。一般的に、パラメータ数が多いモデルほど、より高度なタスクを実行できる能力を持ちますが、その反面、処理に必要な計算リソース(処理サイクル、メモリ、電力)も増加します。

一方、パラメータ数が少ないモデルは、より軽量でリソース消費を抑えられますが、実行できるタスクの複雑さには限界があります。Gemma3では、このトレードオフを考慮して、様々な利用シーンに対応できるように複数のサイズが用意されています。

さらに、Gemma3は量子化(Quantization)と呼ばれる技術をサポートしており、モデルの重みの精度を低くすることで(例えば32ビットから4ビットへ)モデルサイズを削減し、推論速度を向上させることが可能です。

Gemma3は、フル32ビット、BF16(16ビット)、SFP8(8ビット)、Q4_0(4ビット)、INT4(4ビット)といった複数の精度レベルで利用できます。量子化により、VRAMの使用量を大幅に削減できるため、より大きなモデルをコンシューマーグレードのGPUやリソースが限られたエッジデバイスでも実行できるようになります。

Gemma3の動作に必要なハードウェア環境とクラウドやローカルでの展開オプション

Gemma3の動作に必要なハードウェア環境は、選択するモデルのサイズと量子化レベルによって大きく異なります。例えば、27Bモデルは1Bモデルよりも遥かに多くのGPUまたはTPUメモリを必要とします。

具体的なメモリ要件は、S1とS10の表1に示されています。Gemma3は、スマートフォンからラップトップ、デスクトップGPUまで、幅広いコンシューマーハードウェアで動作するように設計されています。

展開オプションも豊富で、Google CloudのGenAI API、Vertex AI、Cloud Run、Cloud TPU、Cloud GPU、そしてモバイルやウェブ向けのGoogle AI Edgeなどが利用できます。

また、Hugging FaceやOllamaといったプラットフォームを通じて、ローカル環境での展開も容易に行えます。特に、事前に量子化されたバージョン(int4など)を利用することで、メモリ要件を大幅に削減し、ローカル環境やリソースが限られたデバイスでの実行が現実的になります。

さらに、Gemma3はNVIDIA GPUでの最適化が進められており、AMD GPUやCPUとの統合もサポートされています.

主要な大規模言語モデルとの比較

Gemini、Llama、DeepSeekといった競合モデルとの機能や性能の違い

Gemma3はGoogleのGeminiの技術を基に構築されていますが、一般的にGeminiモデルの方がパラメータ数が多く、コンテキストウィンドウも大きい(例えばGemini 2.0 Proは200万トークンのコンテキストウィンドウを持つ)ため、より高度なタスクを実行できると考えられます。

また、GeminiはAPIを通じてアクセスするクローズドソースモデルであるのに対し、Gemma3はオープンソースモデルであり、モデルの重みが公開されているため、ローカルでの展開やカスタマイズが可能です。Gemma3の大きな特徴の一つであるマルチモーダル機能は、LlamaやDeepSeekといった主要なオープンソースモデルのコア機能にはまだ含まれていません(ただし、拡張機能や統合は存在します)。

性能面では、Gemma3はGemini 1.5や2.0の精度には及ばないものの、そのサイズを考慮すると、クローズドソースのGeminiモデルと比較しても遜色ない性能を示しています。

コンテキストウィンドウのサイズも、Gemma3は最大128Kトークンであるのに対し、LlamaやDeepSeekの多くのバージョンではこれよりも短いですが、最新のモデルではより長いコンテキストウィンドウを提供するものも出てきています。パラメータ数を見ると、Gemma3はDeepSeek-R1(671Bパラメータ)やLlama 3(最大405Bパラメータ)と比較してかなり少ないです。

各種ベンチマークにおけるGemma3の評価結果の分析と強み・弱点の明確化

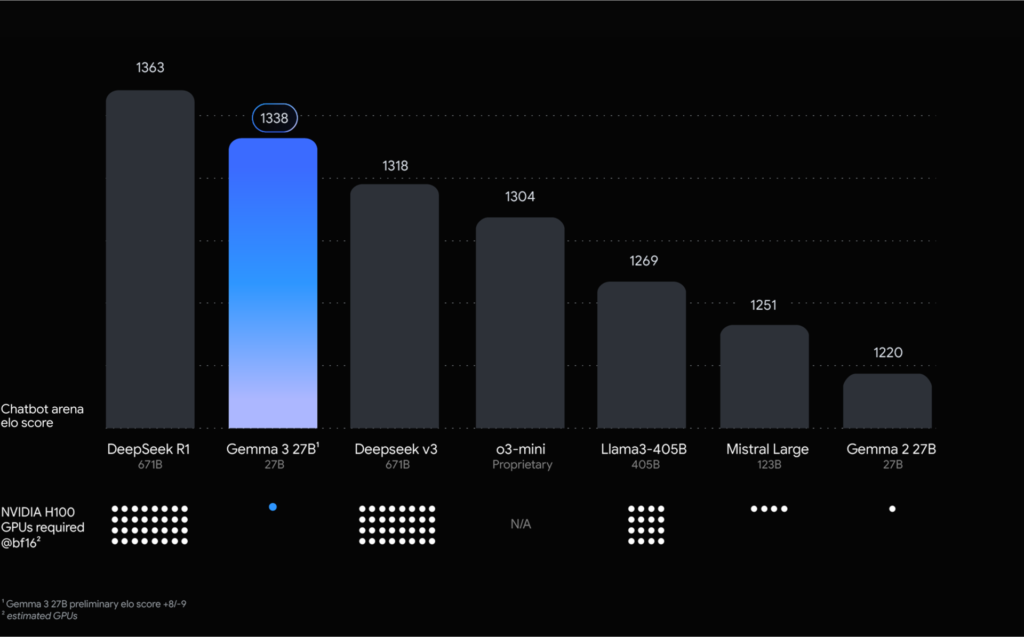

Gemma3は、様々なベンチマークで高い性能を示しています。LMArenaのリーダーボードでは、27Bモデルが1338のEloスコアを獲得し、Llama-405BやDeepSeek-V3を上回る評価を得ています。

特に、数学の問題解決能力を測るMATHベンチマークでは69.0%、コード生成能力を評価するLiveCodeBenchでは29.7%、そして知識と問題解決能力を測るMMLU-Proでは67.5% という高いスコアを記録しています。

また、Googleの推定によると、Gemma3はDeepSeekのR1の精度を98%達成しながら、使用するGPUの数は大幅に少ない(単一GPU対32GPU)とされています。効率性においても、Gemma3-4B-ITモデルはGemma 2-27B-ITモデルと同等の性能を示しており、27B-ITモデルはMATH(89.0%)、LiveCodeBench(29.7%)、MMLU-Pro(67.5%)といった専門分野のベンチマークで非常に高いスコアを達成しています。

一方で、基本的な事実に関する質問を評価するSimpleQAベンチマークでは、Gemma3はやや低いスコアとなっています。また、学術研究においては、Gemma3がChatGPT-3.5を全てのクエリで上回るスコア(100%)を達成したという報告もあります。

これらの結果から、Gemma3は、推論、コーディング、数学といった分野で特に強みを発揮する一方、基本的な知識の検索においては改善の余地があると言えるでしょう。

参照記事

特定のタスク(推論、コーディング、数学など)におけるGemma3の優位性を具体的に示す

Gemma3は、特に高度な推論能力が求められるタスクにおいて優れた性能を発揮します。

MATHベンチマークやLiveCodeBenchでの高いスコアは、数学的な問題解決能力とコード生成能力の高さを具体的に示しています。また、最適化されたトレーニングプロセスにより、ユーザーの指示をより正確に理解し、従う能力が向上しています。

そのため、論理的思考、記号表現、そして数学的な問い合わせへの対応が求められるアプリケーションにおいて、Gemma3は非常に有効なツールとなり得ます。

さらに、128Kトークンという大きなコンテキストウィンドウにより、長いコードシーケンス全体を一度に処理できるため、大規模なプロジェクトでも一貫性のあるアドバイスやコード補完が可能になり、学生の学習効率を30%向上させたという報告もあります。

これらの点から、Gemma3は、複雑な推論、問題解決、そして構造化された出力(例えばコード)の生成を必要とする開発者や研究者にとって、非常に魅力的な選択肢と言えるでしょう。

Gemma3と主要LLMのスペック比較

| モデル | パラメータ数 | コンテキストウィンドウ | マルチモーダル対応 | 言語サポート | オープンソース | 推定VRAM (4-bit) | Eloスコア (LMArena) |

| Gemma3 1B | 10億 | 32K | No | 英語のみ | Yes | 0.6 GB | – |

| Gemma3 4B | 40億 | 128K | Yes | 140以上 | Yes | 2.3 GB | – |

| Gemma3 12B | 120億 | 128K | Yes | 140以上 | Yes | 6.9 GB | – |

| Gemma3 27B | 270億 | 128K | Yes | 140以上 | Yes | 15.5 GB | 1338 |

| Gemini (概算) | 不明 | 200万 (Pro) | Yes | 40以上 | No | 不明 | – |

| Llama 3 (8B) | 80億 | 8K | No | 不明 | Yes | 不明 | – |

| Llama 3 (70B) | 700億 | 8K | No | 不明 | Yes | 不明 | – |

| DeepSeek-R1 (概算) | 6710億 (370億アクティブ) | 128K | No | 不明 | Yes | 不明 | 1363 |

*注 Gemini、Llama 3、DeepSeek-R1のVRAM要件は、公開されている情報が限られているため「不明」としています。Eloスコアは変動する可能性があります。

Gemma3の多様な活用事例

AIチャットボットの機能向上にGemma3がどのように貢献できるか

Gemma3の持つ高度な文脈理解能力と自然な言語生成能力は、AIチャットボットの機能性を大幅に向上させる可能性があります。より大きなコンテキストウィンドウにより、チャットボットはより長く、一貫性のある会話を維持し、ユーザーの意図を深く理解した上で、より人間らしい自然な対話を実現できます。

また、広範なトレーニングデータから得られた知識を活用することで、より正確で関連性の高い回答を提供することも期待できます。

さらに、関数呼び出し機能を利用することで、単に質問に答えるだけでなく、外部システムと連携して実際のアクションを実行できる、より高度なチャットボットを構築することも可能です。

これらの機能により、Gemma3は、顧客サポート、バーチャルアシスタント、インタラクティブなアプリケーションなど、様々な分野でより高度なAIチャットボットの開発を促進するでしょう。

コンテンツ生成、文章要約、質問応答といった一般的なタスクへの応用例

Gemma3は、コンテンツ生成、文章要約、質問応答といった、大規模言語モデルの一般的なタスクにおいても優れた性能を発揮します。

例えば、ブログ記事、マーケティングコピー、メールの草稿、脚本、詩など、多様な形式のテキストコンテンツを生成することができます。また、大きなコンテキストウィンドウを活かして、長文のドキュメント、研究論文、レポートなどを効率的に要約することも可能です。

さらに、広範な知識ベースと高度な推論能力により、様々なトピックに関する質問に対して、正確かつ包括的な回答を提供することができます。多言語対応能力も高いため、異なる言語でのコンテンツ作成や翻訳支援などにも応用できます。

特定の業界(例 教育、研究、ビジネス)における具体的な活用シナリオ

Gemma3の持つ多様な機能と高い性能は、様々な業界において具体的な活用シナリオを生み出す可能性があります。教育分野では、個々の学習ニーズに合わせた教材の作成、複雑な概念の説明、語学学習のサポートなどに活用できます。

研究分野では、大量の文献調査の効率化、研究データの分析支援、仮説生成のサポート、さらには創薬研究の加速(TxGemmaのような特化モデル)などへの応用が期待されます。

ビジネス分野では、顧客対応を自動化する高度なチャットボットの構築、マーケティングコンテンツの生成、ビジネス文書の分析、プログラミング支援、関数呼び出しによる業務ワークフローの自動化、そして営業プロセスの改善などが考えられます。

また、NVIDIA Jetsonのような組み込みデバイスへの展開も可能であるため、ロボティクスやエッジAIの分野での応用も期待されています。

Google AIの全体戦略の中でGemma3が担う役割の考察

Gemma3は、Googleが有用なAI技術をよりアクセスしやすくし、AI開発コミュニティにおけるイノベーションを促進するという戦略において、重要な役割を担っています。

Googleの最先端クローズドソースモデルであるGeminiと同じ研究と技術を基に構築されたGemmaモデルをオープンソースとして提供することで、高度なAI機能をより多くの開発者や研究者が利用できるようになります。

Vertex AIやGKEといったGoogle Cloudプラットフォームとの統合も進められており、スケーラブルなAIアプリケーションの構築と展開を支援します。

また、Gemma3のトレーニングと設計には、安全性フィルタリングやGoogleのAI原則への準拠など、責任あるAI開発への強いコミットメントが反映されています。

さらに、安全性に特化したShieldGemma 2や、視覚機能に特化したPaliGemma 2といった、Gemmaファミリー内の特化モデルの開発も、GoogleのAI戦略における多様なニーズへの対応を示唆しています。

Gemma3利用開始ガイド

開発者がGemma3を使い始めるための具体的なステップの紹介

開発者がGemma3を使い始めるには、まずKaggle やHugging Face といったプラットフォームからGemma3モデルをダウンロードする必要があります。これらのプラットフォームでは、Gemma3のモデルウェイトが公開されており、利用規約に同意することで誰でも無料で利用できます。

Googleのオープンモデルに関する実践的な例やチュートリアルは、ai.google.devのGemmaガイド で提供されています。また、モデルカードや技術レポートなどの包括的なドキュメントも用意されており、より詳細な情報を得ることができます。

Google AI Studio、Hugging Face、Ollamaなどの利用方法の解説

Gemma3を試すためのプラットフォームとしては、Google AI Studio、Hugging Face、Ollamaなどが挙げられます。

Google AI Studio は、ブラウザ上でGemma3を直接体験できる無料の環境を提供しており、セットアップなしですぐに利用を開始できます。APIキーを取得することで、Google GenAI SDKを通じてGemma3を利用することも可能です。

Hugging Face は、Transformersライブラリを通じてGemma3を提供しており、PythonでTransformerモデルを扱うための豊富なツールを利用できます。Hugging Face Spaceでは、Gemma3のインタラクティブなデモを試すこともできます。

Ollama は、ローカルのGPU上でGemma3モデルを実行するための便利なツールであり、ローカル環境での利用を希望するユーザーに適しています。

さらに、Gemma Pythonライブラリ を使用すると、Gemmaモデルとのチャットやファインチューニングを簡単に行うことができます。

ファインチューニングやカスタマイズの基本的な概念に触れる

Gemma3モデルは、事前学習済みモデルと指示チューニング済みモデルの両方が提供されており、特定のユースケースやドメインに合わせてファインチューニング(Fine-tuning)することが可能です。

ファインチューニングとは、大規模なデータセットで事前に学習されたモデルを、より小さなタスク固有のデータセットで追加学習させることで、特定のタスクにおける性能を向上させる手法です。

Gemma3の刷新されたコードベースには、効率的なファインチューニングと推論のためのレシピが含まれており、Google ColabやVertex AIといったプラットフォームを利用して、比較的容易にファインチューニングを行うことができます。

ファインチューニングにより、Gemma3を自身の特定のニーズに合わせてカスタマイズし、専門的なタスクにおいてより高い精度を実現することが期待できます。

まとめ

Gemma3は、Googleが提供する最新のオープンソースAIモデルであり、その機能と高性能は、生成AIの分野に新たな可能性をもたらします。マルチモーダル対応、128Kトークンという広大なコンテキストウィンドウ、そして140以上の言語をサポートする多言語対応は、他の主要な大規模言語モデルと比較しても際立った特徴です。技術的な側面においても、最適化されたTransformerアーキテクチャと効率的なトレーニングプロセスが、その高いパフォーマンスを支えています。

Gemma3の可能性を最大限に引き出すためには、まず実際にこれらのプラットフォームを通じてモデルを体験し、その基本的な機能に触れてみることをお勧めします。リソースが限られている場合は、より軽量な1Bまたは4Bモデルから試してみると良いでしょう。より高度なアプリケーション開発を目指す場合は、関数呼び出し機能の活用や、独自のデータセットを用いたファインチューニングを検討してみてください。

【1分で完了】AI活用度診断

あなたのAI活用度を5つの観点で診断し、レーダーチャートで可視化。得意分野と伸ばすべきAIスキルが一目でわかります。

診断は無料で1分程度で完了するので、自分のAIスキルを伸ばしたい方はぜひ診断してみてください。

コメント